Apple Étend les fonctionnalités de sécurité des enfants de l’iPhone au Royaume-Uni

Longtemps après sa sortie initiale en août, et après une controverse considérable sur le composant qui n’a pas encore été publié, Apple Une fonctionnalité iPhone est étendue au Royaume-Uni pour protéger les enfants contre l’envoi ou la réception de contenu pornographique.

La sécurité des communications dans les messages a finalement été déployée dans le cadre de la mise à jour du point iOS 15.2 en décembre. Cependant, jusqu’à présent, cela s’est limité aux États-Unis.Le Guardian a rapporté que Apple Des plans ont été annoncés pour apporter la fonctionnalité au Royaume-Uni, mais le calendrier reste flou.

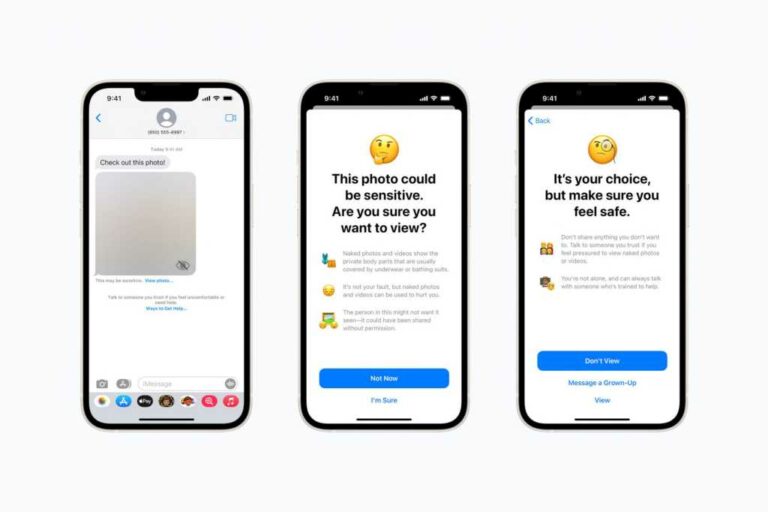

Lorsqu’elle est activée sur l’appareil d’un enfant, la fonctionnalité utilise un outil d’intelligence artificielle sur l’appareil pour analyser toutes les photos qu’elle reçoit via des messages à la recherche de nudité. Si elle est trouvée, l’image sera floue et les utilisateurs seront avertis qu’elle peut contenir du contenu sensible ainsi que des liens vers des ressources utiles.Encore une fois, l’outil scanne les photos envoyées traverser Les enfants, s’ils trouvent de la nudité, il leur est conseillé de ne pas envoyer de matériel et de contacter un adulte.

« Le message analyse les images jointes et détermine si la photo contient de la nudité tout en maintenant le cryptage de bout en bout du message. » Apple Explique. « La fonction est conçue pour que l’appareil ne détecte aucun signe de nudité. Apple Il n’y a aucun accès à ces messages et aucune notification aux parents ou à quiconque. «

refléter Apple D’après l’expérience des groupes de protection de la vie privée, la fonctionnalité a été édulcorée par rapport à ses plans d’origine. Dans son concept original, la fonctionnalité comprenait une option parentale pour avertir automatiquement les parents si de la nudité était détectée dans les images envoyées ou reçues par des enfants de moins de 13 ans. Apple L’aspect a été supprimé après que des inquiétudes ont été exprimées concernant le risque de violence ou d’abus parental. La fonctionnalité permet désormais aux enfants d’envoyer un message à des adultes de confiance lorsqu’ils le souhaitent, indépendamment de la décision de visualiser les images, et les parents ne seront pas avertis à moins que l’enfant ne le choisisse.

Un certain nombre de fonctionnalités de sécurité pour enfants – qui incluent également un outil d’IA controversé qui utilise des hachages pour numériser des photos téléchargées sur iCloud et les comparer à une base de données de matériel connu d’abus sexuels d’enfants – étaient initialement prévues pour iOS 15 de l’année dernière. mise à jour apparaît. Apple La composante CSAM a été retardée à la fin de l’année dernière mais n’a pas encore été mise en œuvre.

Qu’est-ce que cela signifie pour moi?

Les lecteurs américains ne sont pas concernés par cette nouvelle, car la fonctionnalité est active depuis iOS 15.2.Si la sécurité des communications dans les messages est étendue à un deuxième pays, nous pouvons en déduire Apple Les résultats sont mitigés et il est peu probable qu’il soit fait marche arrière et supprimé aux États-Unis. Cette fonctionnalité n’affecte que les images reçues dans Messages et ne numérise aucune photo stockée dans la photothèque de votre enfant.

Les lecteurs britanniques avec enfants auront bientôt la possibilité (désactivée par défaut) d’activer la fonctionnalité sur le téléphone de leur enfant, en activant l’analyse sur l’appareil pour le contenu potentiel. Mais comme nous l’avons expliqué ci-dessus, les résultats de ces analyses ne sont pas automatiquement partagés avec les parents, mais si vous prévoyez d’activer la fonctionnalité, il est sage de l’intégrer à une discussion plus large sur les choses à faire et à ne pas faire en matière de partage numérique.