Apple Report des plans de recherche de pornographie juvénile dans iOS

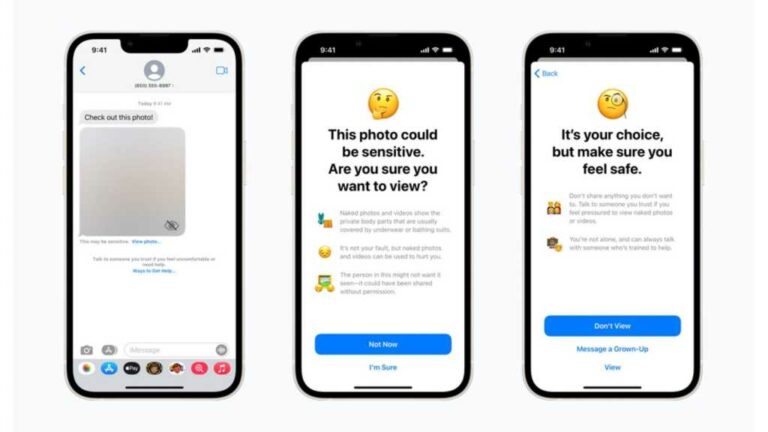

lundi 13 décembre 2021 Apple Sortie de la version finale d’iOS 15.2. La mise à jour de la société corrige certaines failles de sécurité et apporte de nouvelles fonctionnalités, notamment de nouvelles protections pour les enfants, notamment des avertissements pour le contenu explicite dans iMessage et une protection pour les recherches via Siri, Spotlight et Safari. La société a annoncé les changements au début de 2021.

Ces protections signifient que dans iOS 15.2, les parents peuvent activer un avertissement si un enfant reçoit ou envoie du contenu explicite.

Les changements sont détaillés sur la page de sécurité des enfants d’Apple, mais un article de Reddit a noté qu’une section de cette page avait disparu : annonçant l’examen par CSAM d’iCloud Photos.

La page d’Apple sur les prochaines fonctionnalités de sécurité pour les enfants a été mise en ligne le 5 août. La dernière version est datée du 13 décembre et supprime toute référence aux informations liées à l’examen du CSAM. Le paragraphe correspondant sur la page était auparavant le plus complet des trois éléments de sécurité. aussi, Apple Des références ont été faites à des documents techniques, tels que des livres blancs et des revues d’innovations par des chercheurs. Les fichiers PDF eux-mêmes sont toujours en ligne, mais tous les liens dans les pages d’annonce sont maintenant manquants.

Apple Il a fait face à un contrecoup pour avoir annoncé qu’il vérifierait les photos iCloud pour les images représentant du matériel d’abus sexuel d’enfants. Les gens sont clairement plus préoccupés par l’invasion de leur propre vie privée que par la façon dont les enfants sont protégés.mais pas tous Apple L’utilisateur est le parent. Craig Federighi d’Apple a expliqué que les scans de photos d’Apple étaient « largement mal compris » dans une interview d’août avec le Wall Street Journal.

La société a ensuite mis à jour sa page Web sur la sécurité des enfants en septembre 2021, indiquant :

« Auparavant, nous avons annoncé des plans fonctionnels pour aider à protéger les enfants contre les prédateurs qui utilisent des outils de communication pour les recruter et les exploiter, et pour aider à limiter la propagation de matériel d’abus sexuel d’enfants. Selon les clients, les groupes de défense, les chercheurs et autres. Sur la base des commentaires des personnes, nous avons décidé de passer plus de temps à recueillir des commentaires et à apporter des améliorations au cours des prochains mois avant de publier ces fonctionnalités vitales pour la sécurité des enfants. »

Maintenant, les plans d’Apple pour cela ne sont pas clairs pour le moment. Si le plan est toujours retardé ou n’est plus prévu du tout.

espoir Apple Peut trouver un moyen d’identifier ce matériel criminel Apple Les utilisateurs n’ont pas le sentiment qu’il s’agit d’une atteinte à leur vie privée.

Cet article a été initialement publié sur Macwelt. Traduit par Karen Haslam.