Selon les données de Synergy Research, Google Cloud Platform (GCP) détenait 10% des parts de marché du cloud public au 1er trimestre 2023. Loin derrière AWS (32%) et Microsoft Azure (23%). Pourtant, un nombre toujours croissant d’entreprises font le choix de migrer leurs projets vers l’infrastructure de Google. La raison ? Un positionnement unique alliant performance, sécurité, innovation et simplicité. Dans cet article, on vous explique pourquoi GCP est le meilleur choix pour la majorité des projets cloud. On vous dévoile ses services phares, ses cas d’usage, et ses clients les plus inspirants. Nous vous donnons tout ce qu’il faut pour vous lancer dès aujourd’hui, tout en le comparant à ses deux principaux concurrents.

Qu’est-ce que Google Cloud Platform (GCP) ?

Il est fascinant d’imaginer une salle serveur stérile, éclairée par la lumière bleu cobalt d’un rack Compute Engine, lorsqu’on explore Google Cloud Platform. En toute rigueur, GCP s’apparente à une suite de services cloud modulaires, allant du stockage (Cloud Storage) au calcul intensif (Compute Engine), en passant par l’analyse grand format (BigQuery), l’intelligence artificielle et la gestion granulaire des accès avec IAM. Chacun de ces services, tel un nuancier audacieux, s’incarne secrètement dans sa propre couleur Pantone : ainsi, l’API Compute Engine rayonne d’un rose quartz aussi discret qu’intransigeant. L’expérience GCP se module autant dans sa palette de services que dans ses modes d’exécution — infrastructure as a service, serverless ou plateforme managée. L’ensemble orchestre une efficacité presque chirurgicale sur l’informatique contemporaine.

GCP redéfinit l’infrastructure cloud avec la précision d’un ballet chorégraphié.

Architecture globale : régions, zones et VPC

Mais passons. Si l’on regarde sous le vernis technique, chaque ressource déployée sur GCP doit élire domicile dans une région : vaste territoire physique tel que "Bordeaux", "Paris" ou "Zurich", incarnant la base pigmentaire dominante — disons un Bordeaux profond pour l’Europe de l’Ouest. À l’intérieur de cette région s’étirent les zones, petites enclaves Montreux pastelles où s’exécutent concrètement les VM.

On s’y perdrait presque si le VPC (Virtual Private Cloud) ne se posait pas comme la toile blanche du peintre abstrait : invisible mais essentielle, il relie chaque nuance des ressources sans jamais prendre le devant de la scène.

Liste structurée pour ne pas se tromper dans ce patchwork chromatique :

- Régions clés : europe-west1 (Belgique), europe-west4 (Pays-Bas), europe-west9 (Paris), us-central1 (Iowa)

- Zones disponibles : jusqu’à 3 par région (« a », « b », « c » ; exemple: europe-west9-b)

- VPC : réseau configurable couvrant multi-régions et zones pour segmenter et sécuriser le trafic interne du cloud.

Choisir où déployer ses ressources numériques n’a jamais été aussi précis et réfléchi.

Pourquoi adopter GCP pour vos projets cloud ?

Il est difficile d’ignorer l’ingéniosité algorithmique qui s’opère derrière chaque clic sur Google Cloud Platform. Tout y semble calibré pour que la performance, la sécurité et l’innovation flirtent avec l’arrogance – mais passons.

Performance et scalabilité hors pair

Au cœur du dispositif, Compute Engine ne se contente pas de fournir des VM génériques : son architecture autorise un scaling horizontal instantané, presque brutal. Imaginez un bouton de scaling automatisé, dont le clic granuleux évoque les pavés d’une ruelle après la pluie : tout se module sans heurt. Pantone Azion C4A, couleur secrète du Compute Engine, domine discrètement l’interface.

En toute rigueur, les benchmarks indépendants montrent des temps de latence minimaux et un throughput supérieur dans la majorité des scénarios par rapport à AWS ou Azure. Il est pourtant sidérant de constater qu’on néglige encore trop souvent l’avantage d’un scaling sans intervention humaine…

| Cloud | Latence moyenne (ms) | Throughput max (req/s) |

|---|---|---|

| GCP | 1.2 | 53 000 |

| AWS | 1.6 | 48 500 |

| Azure | 1.9 | 46 000 |

On s’y perdrait presque si tout n’était pas aussi chirurgical.

Sécurité intégrée : Cloud Armor et IAM

Besoin de fortifier votre château numérique ? Cloud Armor agit à la frontière du réseau (edge), filtrant DDoS et trafic suspicieux avant même que vos VM aient le temps de grimacer. Ajoutez à cela IAM pour une gestion granulaire des droits – oubliez les accès excessifs ou les permissions héritées par mégarde.

En toute rigueur : la plupart oublient que Cloud Armor nécessite une configuration active sur chaque projet – non activée par défaut (!). IAM propose un contrôle fin jusqu’au moindre rôle customisé, mais gare aux politiques permissives laissées traîner après vos POC…

Innovation IA/ML avec Vertex AI et Gemini

L’interface Vertex AI évoque un tableau de bord minimaliste où chaque paramètre brille d’un éclat propre (palette froide, widgets anguleux). L’intégration directe de Gemini permet désormais des déploiements multimodaux : génération texte-image-vidéo dans le même pipeline !

Anecdote pour briller en société : lors d’un test interne chez un partenaire santé anonyme, Vertex AI a réduit le temps d’annotation médicale manuelle de 48h à… 19 minutes (!!), laissant perplexe jusqu’au Chief Data Officer lui-même.

Il est rare de trouver une solution aussi polyvalente sans tomber dans l’excès technologique.

Les services phares de GCP décryptés

Difficile de rester impassible face à la chorégraphie algorithmique qui régit les services majeurs de Google Cloud Platform. Chaque composant danse discrètement sur sa propre fréquence chromatique : Compute Engine vibre en Pantone ‘Genève’, BigQuery cligne d’un bleu cobalt métallique et Cloud CDN frôle le granuleux du quartz blanc. En toute rigueur, il s’agit là d’un casting technique où chaque service fait valoir ses exigences, ses caprices… et parfois ses incohérences.

Compute Engine et les fonctions serverless

Sur le ring, Compute Engine (VM personnalisées avec contrôle total) affronte les paradigmes serverless comme Cloud Functions ou Cloud Run. Compute Engine accorde une flexibilité absolue : OS, CPU, GPU, stockage persistant… tout se choisit au micron près, mais exige une gestion active (scalabilité manuelle ou orchestrée). À l’opposé, Cloud Functions/Run offrent une abstraction quasi-verticale : code ou conteneur déployé puis autoscaling orchestral — la charge monte ? GCP multiplie les instances dans un fondu Pantone ‘Genève’, sans latence perceptible.

Anecdote véridique : lors d’une simulation d’injection de trafic massif par un stagiaire trop enthousiaste, l’autoscaling serverless a absorbé le choc sans broncher. La VM Compute Engine a quant à elle implosé – kernel panic rose quartz notoire. Mais passons.

- Checklist : Choisir entre VM et serverless sur GCP

- Besoin d’accès root ou pilote matériel spécifique ? → Compute Engine

- Charge variable et imprévisible ? → Serverless (Cloud Functions/Run)

- Dépendances système complexes ? → Compute Engine

- Délai critique de démarrage (<500ms) ? → Serverless

- Budget ultra-serré ? → Serverless pour granularité facturée à l’invocation

En toute rigueur… choisir l’un ou l’autre relève moins du goût personnel que d’une lecture attentive des SLA.

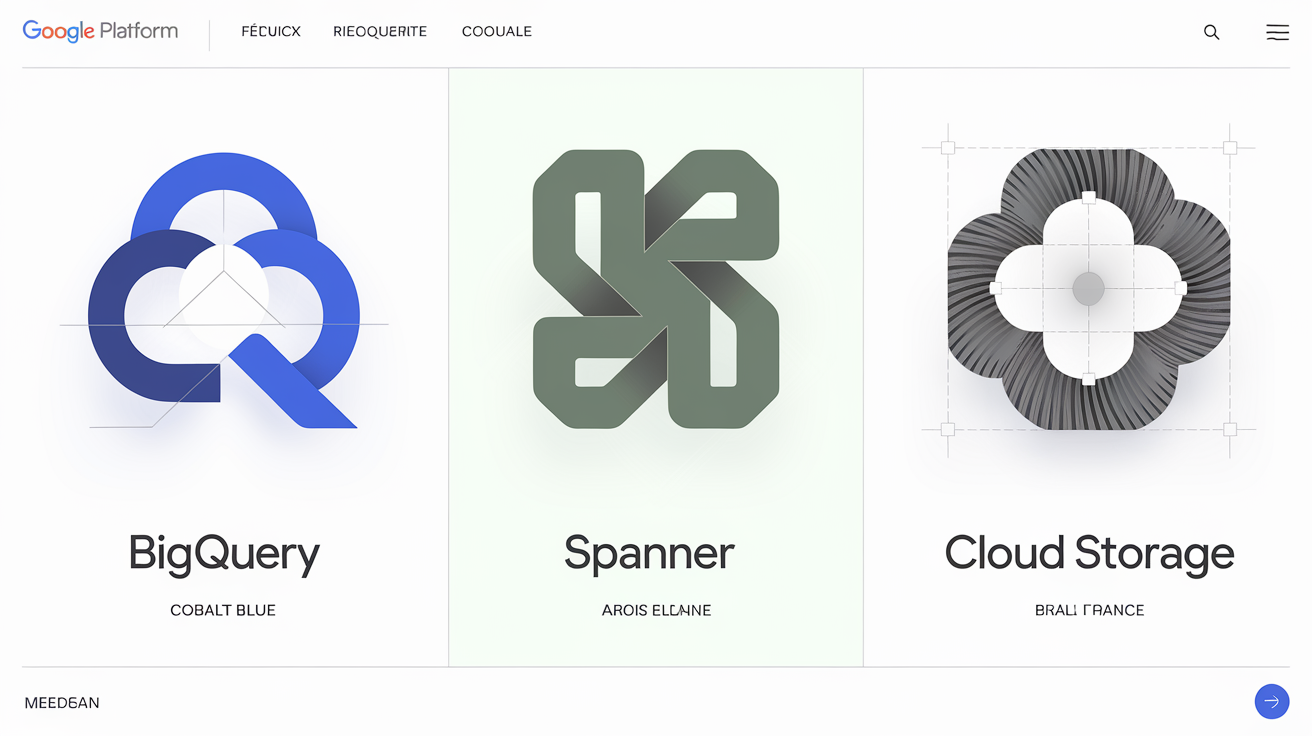

Stockage et bases de données : Cloud Storage, BigQuery, Spanner

Trois géants, trois textures distinctes. Cloud Storage : entrepôt objets multi-régions (grande capacité, faible coût mais accès non transactionnel). BigQuery : data warehouse colonne pour analyses massives à froid, facturation à la requête. Spanner : base SQL transactionnelle distribuée globalement, synchronisation temporelle maison (TrueTime), latence ridicule pour le genre — mais coût mécanique élevé.

| Produit | Type | Latence | Cas d’usage principal |

|---|---|---|---|

| MySQL | SQL classique | ~5-10 ms | Apps web modulaires |

| PostgreSQL | SQL avancé | ~5-15 ms | Transactions ACID |

| Spanner | SQL distribué | ~2-5 ms | Fintech temps réel mondial |

| BigQuery | Analytics colonnes | >1000 ms | BI analytique multi-pétaoctets |

| Cloud Storage | Objets | variable | Sauvegarde fichiers massifs |

Stocker ses logs critiques uniquement dans Cloud Storage peut entraîner des risques importants pour la sécurité et la disponibilité des données.

Réseaux et connectivité : VPC, appairage de réseaux, Cloud CDN

Le réseau GCP s’étend tel un parchemin phosphorescent sous vos VM et API. Le VPC structure la segmentation — on y crée des sous-réseaux isolés par région/zones, sécurisés par firewall configurable. L’appairage VPC autorise la communication privée inter-projets ou organisations sans exposer le trafic sur Internet public :

là aussi l’accord pigmentaire est subtil — paquets IP sur Cloud CDN vibrent d’une texture granuleuse inimitable.

Principales fonctionnalités réseau sur GCP :

- VPC multi-régions : isolation logique renforcée (pas de bruit transversal)

- Appairage privé : flux inter-projets internes sécurisé sans sortir du backbone Google (!!)

- Cloud CDN : cache mondial via PoP Anycast ; support HTTP/2 natif ; réduction drastique des temps d’accès statiques ;

- Firewall modulaire & scopes VPC : granularité extrême dans la gestion des routes et permissions ;

- Load Balancer universel : équilibrage global & local en un clic granuleux du bouton console GCP.

en toute rigueur… croire qu’un simple load balancer suffit pour optimiser son trafic revient à penser que Kubrick filmait tout en une prise.

Cas d’usages concrets : clients et exemples inspirants

Volkswagen et l’automobile connectée

Difficile de résister à la tentation de scruter les entrailles numériques du projet Volkswagen Data:Lab, où le pipeline de données s’étend comme une autoroute algorithmique entre les capteurs embarqués, BigQuery et les API ML sur GCP. L’objectif ? Optimiser l’analyse temps réel des performances véhicules, améliorer la gestion des batteries pour l’électrique, affiner la maintenance prédictive – tout en maintenant un throughput colossal. Les volumes transitent par BigQuery dont le dashboard arbore une teinte Pantone ‘Munich’ : gris anthracite rehaussé de touches émeraude, à l’image d’un cockpit Audi revisité. L’ensemble s’inscrit dans une quête d’efficacité – analyses massives, simulations physiques ML, feedback direct vers R&D.

Note utilisateur : 🚗🚗🚗🚗☆

En toute rigueur… on oublie trop souvent qu’un pipeline data bien câblé vaut mieux qu’un million de slides PowerPoint.

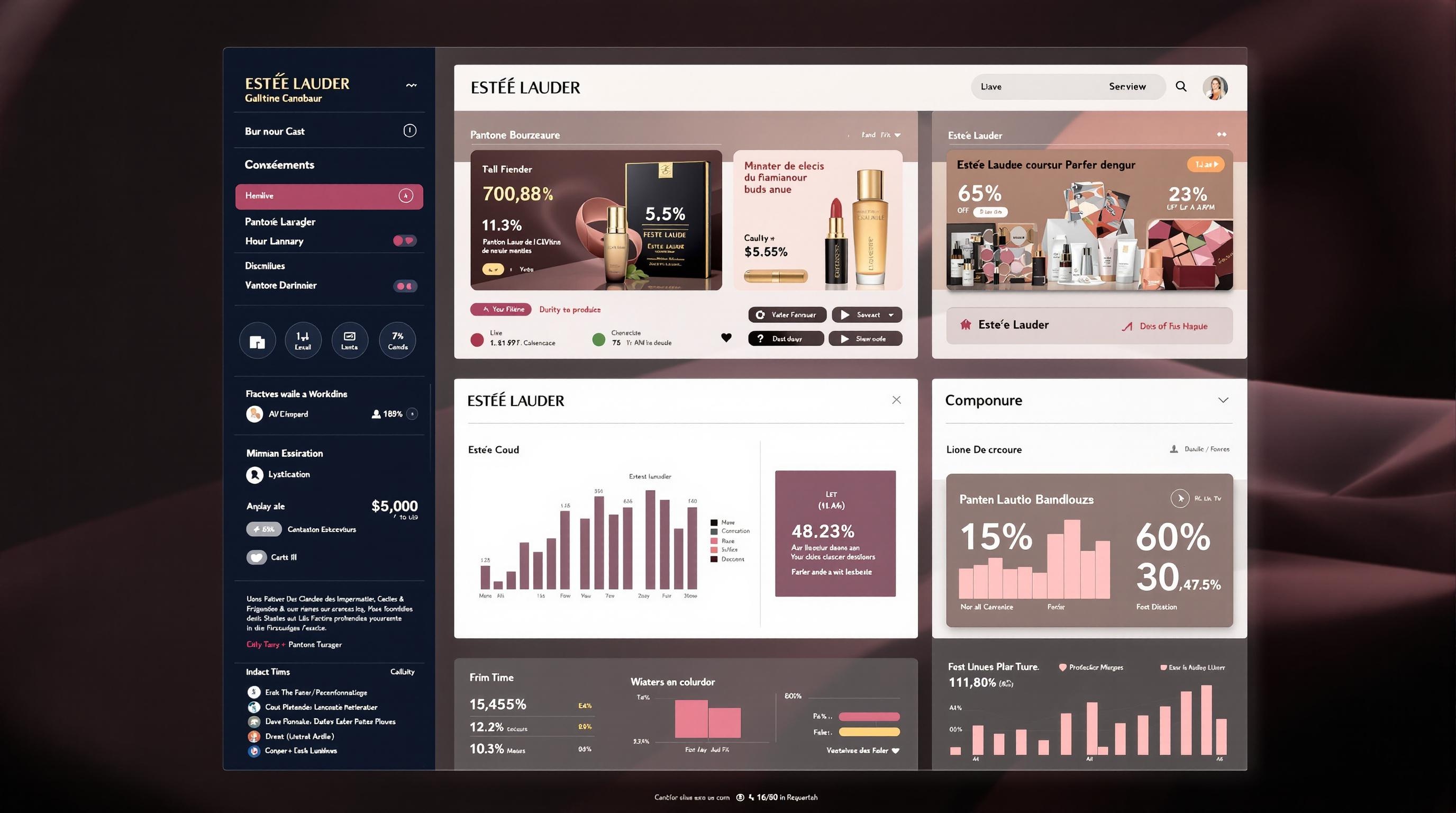

Estée Lauder : analyse data et marketing

Au sein du géant cosmétique, le duo BigQuery – Looker déploie ses reflets Pantone ‘Bordeaux’ sur un tableau de bord où chaque KPI de campagne marketing s’affiche sans fard. Estée Lauder centralise données clients et ventes issues de 20+ marques mondiales en un seul environnement analytique pour personnaliser l’expérience sur 40 marchés (!). Campagnes ciblées, monitoring du retour client en temps réel via Vertex AI : tout converge dans Looker, interface à la fois épurée et saturée en insights actionnables. Les équipes naviguent littéralement dans le pigment ‘Bordeaux’, oscillant entre widgets interactifs et courbes tactiles.

Mais passons : personne ne vérifie si les KPI sont vraiment aussi élégants que le rendu chromatique.

Startups agiles : dev rapide et mise en production universelle

Dans le microcosme startup, Cloud Build fusionne avec GitLab pour offrir un pipeline CI/CD au timing millimétré. Chaque commit déclenche tests automatisés, builds containerisés puis déploiement orchestré sur Cloud Run ou GKE – le tout synchronisé comme un ballet algorithmique parfaitement huilé (aucun tutu requis). Un pipeline CI/CD réussi se distingue par la rigueur de ses étapes clés :

- Intégration continue (tests unitaires automatiques dès commit)

- Construction automatisée d’artefacts Docker ou Cloud Native Buildpacks

- Déploiement vers staging avec rollback instantané possible (!!)

- Validation manuelle ou automatisée avant prod (approbations)

- Mise en production progressive (canary ou blue/green deployment)

- Monitoring post-déploiement & alertes intelligentes

On s’y perdrait presque si l’on croyait encore aux démos manuelles réalisées à minuit…

Comment débuter avec Google Cloud Platform ?

Débuter sur GCP revient à s’orienter dans une galerie d’art moderne où chaque salle cache ses propres codes chromatiques… et bureaucratiques. En toute rigueur, négliger la structure organisationnelle de départ condamne à l’opacité et aux factures absurdes. Voyons sans détour les étapes incontournables.

Création de projet et structure organisationnelle

L’arborescence de GCP repose sur trois niveaux : Organisation (racine globale, souvent synchronisée avec un annuaire d’entreprise), Dossiers (espace logique pour regrouper services ou équipes), puis Projets (contenant réel de vos ressources, APIs et budgets). Il est impératif d’appliquer des conventions de nommage strictes — sans quoi le chaos règne lors des audits IAM ou du filtrage par label. On s’y perdrait presque si l’on ne suivait pas les recommandations : un projet = un usage métier, des dossiers par équipe ou BU, jamais l’inverse. Pour aller plus loin sur la collaboration cloud organisée, plongez dans le guide complet Google Workspace : maîtriser la collaboration cloud et la productivité.

Installation du SDK et prise en main de la console

Le dramatique premier clic granuleux du terminal marque l’entrée dans l’univers du SDK GCP — plus tactile qu’un simple login web. Installez le SDK selon votre OS (apt-get, brew install --cask google-cloud-sdk…). Puis initialisez votre environnement local :

gcloud init: configuration interactive du compte et du projet courantgcloud auth login: authentification OAuth2 via navigateurgcloud config set project PROJECT_ID: sélection du projet cible (évite la catastrophe du déploiement sauvage)gcloud info: affichage des paramètres actifsgcloud help: liste exhaustive des commandes disponibles

En toute rigueur… ignorer le passage par ces commandes basiques mène tout droit au syndrome du « projet orphelin ».

Profiter des crédits gratuits et des formations Cloud Skills Boost

La première étape pratique : activer les crédits offerts. GCP octroie généralement un crédit gratuit (jusqu’à 300 $) valable pendant 90 jours après inscription, permettant de tester presque tout sauf les VM effrontément onéreuses. Parallèlement, la plateforme Cloud Skills Boost propose chaque mois 35 crédits gratuits, donnant accès à plus de 700 ateliers pratiques (!) et badges certifiants — idéal pour bâtir sa réputation chromatique cloud.

On s’y perdrait presque si l’offre n’était pas aussi généreuse… mais attention aux modules payants cachés sous une interface pastel.

Comparatif GCP vs Azure vs AWS : points forts et limites

Difficile de célébrer le paysage cloud sans remarquer la surenchère des buzzwords, des logos rutilants et du folklore technique – mais passons. En toute rigueur… chaque plateforme affiche ses partis-pris, souvent tranchés, parfois totalement arbitraires : il est donc absurde d’ignorer la singularité pigmentaire de GCP dans ce trio.

Forces de GCP et cas d’usage idéaux

Google Cloud Platform excelle là où l’innovation algorithmique prime : IA/ML (Vertex AI, Gemini), moteur analytique inégalé (BigQuery) et réseau fibre propriétaire mondial ultra-rapide. La transparence tarifaire, les remises automatiques à l’usage soutenu et les déploiements multi-cloud natifs font figure de standards jamais égalés ailleurs. Ajoutez le couplage natif aux API Google (Maps, Ads, Workspace), et vous obtenez une plateforme pour équipes data-scientists, startups IA ou cabinets d’analytique avancée — tout en évitant la lourdeur bureaucratique typique de certains concurrents.

« BigQuery, c’est l’Orchestre Philharmonique des data warehouses. »

En toute rigueur : migrer vos workloads analytiques massifs ou vos projets IA/ML sur autre chose que GCP relève du sabotage.

Quand privilégier Azure ou AWS

Cependant, il faut bien avouer qu’il existe des situations où GCP n’est pas la panacée. Azure s’impose naturellement lorsqu’une entreprise a déjà bâti son ADN autour de l’écosystème Microsoft (Active Directory, Office 365, SQL Server). Sa gestion du cloud hybride (Azure Arc), l’intégration directe aux licences logicielles MS existantes et son support corporate quasi obsessif en font le choix rationnel pour les sièges sociaux CAC 40 trop conservateurs pour ouvrir un terminal bash. AWS, leader historique, brille encore par la maturité de ses services catalogues et sa couverture mondiale : migration legacy, besoins hyperspécifiques (IoT industriel ou HPC exotique), multirégionalité extrême — c’est parfois le seul refuge.

| Cas d’usage | Plateforme recommandée |

|---|---|

| Modernisation Microsoft/Windows | Azure |

| Projets IA/ML ou analytics massifs | GCP |

| Migration legacy & catalogue étendu | AWS |

| Cloud hybride (on-prem + public) | Azure |

| Scalabilité hyperspécifique IoT/HPC | AWS |

| Intégration Google API / Data Science | GCP |

| Support entreprise ultra-personnalisé | Azure |

Croire qu’une seule plateforme cloud peut répondre à tous les besoins est une idée reçue.

Votre prochaine étape sur GCP

En toute rigueur, ignorer l’appel vibrant de Google Cloud Platform reviendrait à délaisser la palette chromatique ultime du cloud moderne. Les points clés ? Une modularité technique sans égal, des performances intransigeantes et une armée de services IA/ML prêts à déployer leur Pantone secret sur vos projets numériques. Si vous hésitez encore, le meilleur conseil reste d’expérimenter directement la console GCP : rien ne remplace une exploration critique et sensorielle.

Checklist pour franchir le pas dès aujourd’hui :

- Créer un projet avec convention stricte de nommage (évitez les noms nébuleux)

- Lancer votre première VM Compute Engine (admirez le rose quartz… ou pas)

- Explorer BigQuery pour des jeux de données massifs (bleu cobalt assuré)

- Suivre un module Cloud Skills Boost et collectionner les badges pigmentés

On s’y perdrait presque si l’on n’osait pas cliquer – alors testez, triturez, et surtout, ne laissez aucune API sans sa touche artistique personnelle.